IT之家 8 月 18 日消息,随着 AI 模型体积越来越臃肿,一些研究团队开始提倡效率更高、体积更小的专用模型来取代“大型 LLM 语言模型”。

据《自然》杂志报道,当下 OpenAI 的 ChatGPT 是技术界的新宠,但是当 ChatGPT 遇到一些需要推导的数学问题时,它便会常常犯错,《自然》杂志同时举出一道代数题展示 ChatGPT 的局限性:

(资料图片仅供参考)

(资料图片仅供参考)

一条直线与 y=4x+6 平行且经过 (5, 10)。它和 y 轴的交点的纵坐标是多少?

《自然》杂志表示,虽然 ChatGPT 有时候能给出正确答案,但该模型依然有极高概率回答错误。而在杂志官方进行的早期推导能力测试中,ChatGPT 面对美国中学水平的数学题集时,只答对了 26%。

《自然》杂志同时表示,在 2022 年 6 月,谷歌一款名为 Minerva 的专用数学计算模型突破了业界“大语言模型计算数学不行”观点,据悉,Minerva 在数学题集中答对了 50%,这一结论让 AI 领域的研究者们大为吃惊。

▲ 图源《自然》杂志

▲ 图源《自然》杂志

▲ 图源《自然》杂志

▲ 图源《自然》杂志

微软研究院的机器学习专家 Sébastien Bubeck 彼时对此表示:“在 AI 圈子里,这还真是个新奇事。”

《自然》杂志据此声称,Minerva 模型的结果佐证了研究团队们长时间以来的怀疑:训练更大型的 AI 模型并不是解决“逻辑问题”的正道。

不过,《自然》杂志也对这一观点保留一定意见。他们注意到,有些研究团队的实例表示“更大的模型只是在碰巧与训练集相关的问题上回答得更为出色,而没有获得回答全新问题的能力 ”(IT之家注:因为模型训练数据过多,刚好在训练数据中对比到了类似的问题,所以能给出标准答案)。

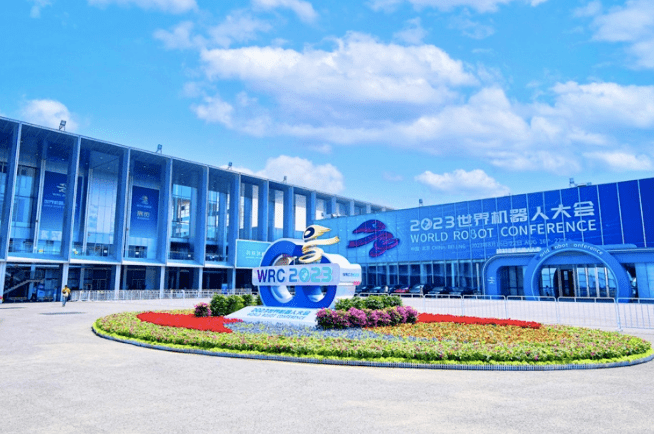

《自然》杂志同时给出了一系列表格,展示了当下大型 AI 模型的参数对比:

▲ 图源《自然》杂志

▲ 图源《自然》杂志

▲ 图源《自然》杂志